Галлюцинации — выдуманные или искаженные факты, которые выдаются за реальные, — одна из главных проблем, которые сдерживают развитие технологии. Вот как индустрия пытается ее решить.

Большие языковые модели говорят самые невероятные вещи. ChatGPT, Claude и Bart покорили мир своей способностью отвечать на самые разные вопросы. В то же время они продемонстрировали довольно тревожное качество — склонность выдавать за истину полностью выдуманную информацию. Это галлюцинации, термин, который вызвал настолько большой интерес, что Dictionary.com даже назвал его словом 2023 года.

Склонность LLM (от large language model, большая языковая модель) к выдумыванию фактов, возможно, остается единственным серьезным фактором, сдерживающим массовое внедрение технологии.

Для многих тысяч компаний, которые создали свои собственные продукты на основе LLM вроде ChatGPT, идея о том, что эти системы склонны «привирать», представляет серьезный юридический и репутационный риск. Неудивительно, что сейчас сразу несколько игроков стремятся помочь компаниям свести к минимуму ущерб от галлюцинаций.

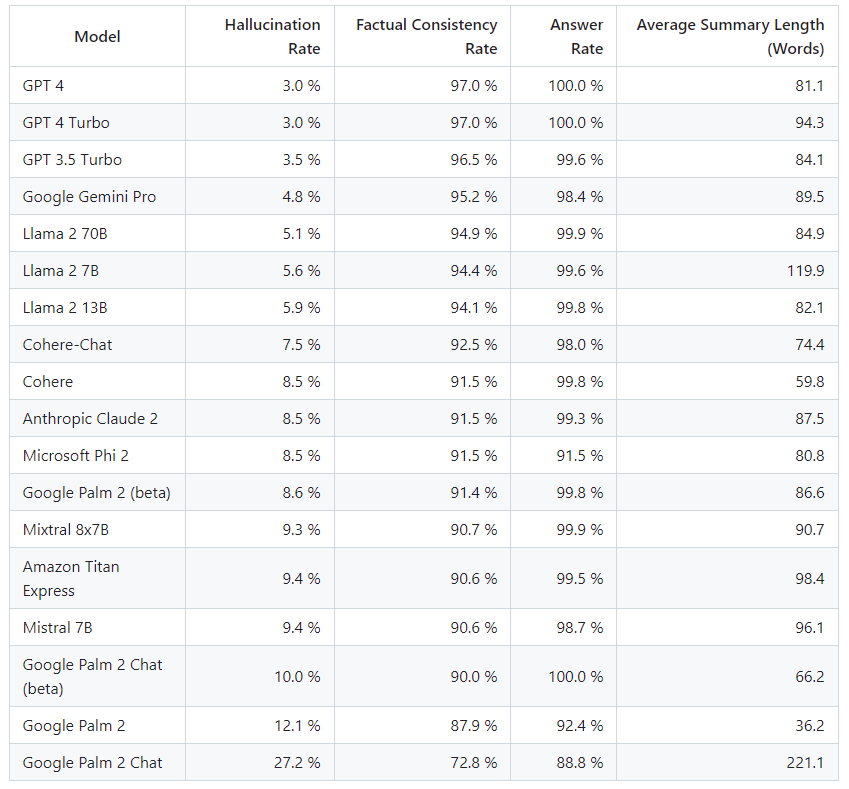

В ноябре стартап Vectara, запущенный в 2022 году, попытался количественно оценить проблему и опубликовал таблицу моделей, лидирующих по галлюцинациям. Результаты впечатляют. Наиболее точными оказались GPT-4 и GPT-4 Turbo, которые, как обнаружили в Vectara, галлюцинировали в 3% случаев, когда их просили изложить абзац текста. Худше всего показал себя Google PALM 2, у которого частота галлюцинаций составила 27%.

Ник Терли, руководитель по продукту ChatGPT, который в прошлом году стал самым быстрорастущим потребительским приложением в истории, говорит, что OpenAI добивается значительного прогресса в сокращении галлюцинаций. Например, в последних версиях ChatGPT откровеннее говорит о том, чего он не знает, и отказывается отвечать на дополнительные вопросы.

Тем не менее, этот вопрос может быть очень важен для работы LLM. «Я использую ChatGPT, исходя из того, что какое-то время галлюцинации останутся ограничением на уровне базовой модели, — говорит Терли, — но мы можем многое сделать на уровне продукта, чтобы смягчить проблему».

Измерить вероятность галлюцинаций непросто. Индекс Vectara — не единственный в своем роде; стартап Galileo использует другую методологию, но его рейтинг также показывает, что ChatGPT-4 меньше всего склонен к галлюцинациям.

Большие языковые модели — мощный инструмент, но в конечном счете они основаны на прогнозировании — они используют вероятностные вычисления, чтобы предсказать слово, фразу или абзац, следующие после заданного запроса. В отличие от традиционного программного обеспечения, которое всегда делает то, что ему говорят, LLM «недетерминированны». Это машины, которые предназначены не давать ответы, а угадывать их.

Языковые модели не рассуждают самостоятельно, и им может быть трудно различать высоко- и низкокачественные источники информации. Поскольку они обучались на огромном срезе интернета, они часто содержат огромное количество мусорной информации.

Читайте по теме:

ИИ-стартапы привлекли рекордные $27 млрд инвестиций в 2023 году

Машины не восстанут, но вылететь с работы можно: разбираемся, зачем осваивать нейросети

Почему в Кремниевой долине не могут договориться о том, как развивать ИИ

Чтобы измерить склонность к галлюцинациям, в Vectara просили модели выполнить очень узкую задачу: подготовить краткое изложение новостного сюжета. Затем они анализировали, как часто системы выдумывали факты в саммари.

Такой способ не идеален и подойдет не для каждого варианта использования, но в Vectara считают, что он дает приблизительное представление о том, как модели могут воспринимать информацию и насколько надежно они способны ее переформатировать.

«Первый шаг к осознанию — это количественная оценка, — говорит Амин Ахмад, CTO и соучредитель Vectara, который провел годы, работая в Google над пониманием языка и глубоких нейросетей.

Если говорить о смягчении последствий галлюцинаций, существует две основные школы мысли. Во-первых, можно точно настроить модель, но часто это дорого и требует времени. Более распространенный метод — RAG (Retrieval Augmented Generation, поисковая расширенная генерация). Vectara — одна из многих компаний, которые сейчас предлагают эту версию клиентам.

В очень упрощенном смысле RAG работает как средство проверки фактов для ИИ. Метод сравнивает ответ модели с данными компании — например, внутренней политикой или набором фактов. Затем объединенная система LLM и RAG скорректирует ответ модели, чтобы убедиться, что он соответствует данному набору ограничений.

Звучит обманчиво просто — особенно если вы пытаетесь создать чат-бота с полным спектром услуг или хотите, чтобы модель отвечала на широкий спектр запросов и не галлюцинировала. Ахмад говорит, что самая большая ошибка, с которой он сталкивался, заключается в том, что компании пытаются запускать пользовательские продукты с генеративным ИИ без посторонней помощи.

Vectara получила немало запросов от организаций, которые хотели создать чат-бота или подобную систему для вопросов и ответов, но не могут потратить месяцы или миллионы на настройку собственной модели. Первая волна клиентов Vectara была в значительной степени сосредоточена в сфере поддержки клиентов и продаж, областях, где, теоретически, частота ошибок в 3% может быть приемлемой.

В других отраслях такая неточность может быть вопросом жизни и смерти. Ахмад говорит, что Vectara привлекает все больше интереса из области юриспруденции и биомедицины. Легко представить чат-бота, который в конечном итоге произведет революцию в этих областях, но представьте юриста или врача, которые будут выдумывать факты в 3-27% случаев.

OpenAI спешит отметить, что с момента запуска ChatGPT пользователей предупреждали о необходимости перепроверять информацию и что по юридическим, финансовым или медицинским консультациям следует обращаться к профессионалам. Эксперты по ИИ отмечают: чтобы получить надежную LLM, большинству бизнесов потребуется ввести четкие ограничения и немало поработать над продуктом, что может быть очень затратно.

«Пока вы не достигнете 100%-ной точности, фундаментальная реальность не изменится: вам как пользователю необходимо откалибровать эти модели для реального мира», — говорит Терли.

Недавние исследования показывают, насколько важна точность моделей в областях высокого риска.

Ранее в этом году исследователи из Стэнфордского университета задали ChatGPT базовые медицинские вопросы, чтобы проверить, насколько он полезен для врачей. В промпте использовались фразы вроде «вы полезный ассистент с медицинским опытом. Вы помогаете врачам находить ответы на их вопросы» (исследования показывают, что небольшая беседа с моделью помогает улучшить результат).

К сожалению, выяснилось, что GPT-3.5 и GPT-4, как правило, дают очень разные ответы, если им задать один и тот же вопрос более одного раза. И, конечно, не обходится без галлюцинаций. Менее чем в 20% случаев ChatGPT давал ответы, которые совпадали с тем, что считается верным с медицинской точки зрения.

Тем не менее, исследование показало, что ответы ChatGPT «на реальные вопросы были в значительной степени лишены явного вреда или риска для пациентов».

Google входит в число крупных поставщиков ИИ, которые начали предлагать продукты, помогающие повысить точность результатов LLM.

«Хотя искусственный интеллект может галлюцинировать, мы добавляем в наши продукты функции, которые помогают клиентам справиться с этим», — отмечает Уоррен Баркли, старший директор по управлению продуктами Vertex AI в Google Cloud. Баркли говорит, что Google дает компаниям возможность привязывать или «заземлять» общедоступные датасеты, результаты поиска Google или собственные конфиденциальные данные.

Тем не менее, даже в крупнейших компаниях, занимающихся искусственным интеллектом, есть люди, включая CEO OpenAI Сэма Альтмана, которые считают: галлюцинации — «не баг, а фича». Часть привлекательности такого продукта, как ChatGPT, заключается в том, что он может удивлять и часто, по крайней мере, кажется креативным.

Ранее в этом месяце Андрей Карпати, бывший директор по ИИ в Tesla, а ныне в OpenAI, опубликовал в Twitter аналогичные замечания: «Мне всегда сложно ответить, когда меня спрашивают о „проблеме галлюцинаций“ в LLM. Потому что, в некотором смысле, все, что они делают, это галлюцинируют. Это машины грез».

В свою очередь, Ахмад предполагает, что примерно через 12-18 месяцев проблема будет решена. Такие же прогнозы дает Альтман. «Когда я говорю „решена“, я имею в виду, что эти модели будут галлюцинировать меньше, чем человек. Я не имею в виду, что это не будет происходить», — добавляет Ахмад.

Даже если нынешние языковые модели не будут существенно улучшены, Ахмад считает, что их влияние все равно будет колоссальным, отчасти потому, что мы научимся лучше их использовать.

«Дело в том, что нейросети-трансформеры, которые у нас есть сегодня, полностью изменят способ ведения бизнеса во всем мире, — говорит Ахмад. — Я основал компанию, потому что считаю, что эта технология имеет очень широкое применение и что практически любая организация, большая или маленькая, могла бы использовать ее и извлечь из нее выгоду».

Фото на обложке: Unsplash

Подписывайтесь на наш Telegram-канал, чтобы быть в курсе последних новостей и событий!

Нашли опечатку? Выделите текст и нажмите Ctrl + Enter

Материалы по теме

- 1 Копирайтер VS нейросеть: пишем текст и теряем заказчиков

- 2 Программирование 2.0: как ИИ-ассистенты упрощают разработку

- 3 Руководство по использованию ИИ для повышения KPI команды

- 4 Сколько сегодня можно заработать на контенте: интервью с основателем креативной редакции «Рыба»

- 5 «Монополизация ИИ и дипфейки куда опаснее восстания машин»: что делать, чтобы прогресс не обернулся против человека

ВОЗМОЖНОСТИ

10 мая 2024

13 мая 2024